Uno de los grandes avances tecnológicos de la Segunda Guerra Mundial fue la creación de la bomba atómica. La película de Christopher Nolan 'Oppenheimer' recoge ese momento histórico en el que la ciencia ocupó las portadas de todos los periódicos del mundo. Para conseguir una bomba tan mortífera, el gobierno de los EEUU reclutó a los mejores científicos de la época en unas instalaciones secretas (Los Alamos Scientific Laboratory, actualmente Los Alamos National Laboratory_). Allí dieron forma al Proyecto Manhattan (1942-1946).

La primera detonación de la bomba atómica, la prueba Trinity se produjo el 16 de julio de 1945.

Pero en Los Álamos ocurrieron muchas más cosas. Entre ellas, el avance tecnológico que hizo posible el uso de computadoras para simulaciones numéricas, algo que permitiría predecir el efecto de las potentísimas ondas de choque del artefacto que estaban creando. Sobre el papel, existía una mínima probabilidad de que generaran un efecto en cadena que acabaría con el mundo.

IMAGEN: Evolución de la bola de fuego de la prueba Trinity, comparada con el Empire State Building a escala. Alex Wellerstein.

Cálculo de las ondas de choque de la bomba

Lo menos conocido de lo que ocurrió en Los Álamos es que el desarrollo de la bomba atómica (y años posteriores) fue el origen de la dinámica de fluidos computacional (término acuñado por Chia-Kun Chu probablemente a partir de 1960). Esta rama de la Mecánica de Fluidos se basa en el uso de computadoras –a través de algoritmos– para resolver problemas hidrodinámicos. Entre ellos, claro, las ondas de choque que genera una bomba atómica.

IMAGEN: Gran explosión convencional. La onda de choque aparece como una línea nítida alejada de la bola de fuego. Stuhmiller J.H., Phillips Y.Y., and Richmond D.R. (1991) The Physics and Mechanisms of Primary Blast Injury. In: Bellamy R.F., Zajtchuk R., eds. Conventional Warfare: Ballistic, Blast, and Burn Injuries. Washington DC: Office of the Surgeon General of the US Army; 241-270.

Los científicos del Proyecto Manhattan no solo desarrollaron las herramientas numéricas para describir las ondas de choque debido a las explosiones. También el uso de computadoras para realizar la complejidad de los cálculos. Los trabajos del matemático John von Neumann sentaron las bases para la fundación moderna de la simulación numérica.

John von Neumann trabajó en el Proyecto Manhattan como asesor en la División Teórica. El líder de dicha división fue Hans Bethe. De 1941 a 1943, Von Neumann elaboro varios informes para el gobierno de los EEUU sobre teoría de ondas de choque, detonaciones y ondas de choque oblicuas.

"Estoy pensando en computadoras"

Recordemos que la bomba desarrollada (de tipo implosión) consistía en una esfera de plutonio rodeada de explosivos. Las cargas, al explosionar, comprimían el núcleo causando la fisión de los átomos. La reacción nuclear descontrolada provocaba la explosión y destrucción total del perímetro.

El mayor desafío de la implosión del núcleo fue diseñar los explosivos que garantizaran una onda de choque simétrica. Los científicos se percataron de que las simplificaciones teóricas eran totalmente inadecuadas. La manera de tratar las complejas ecuaciones era resolverlas numéricamente.

Estoy pensando en algo mucho más importante que las bombas. Estoy pensando en computadoras". John von Neumann.

La aportación más ingeniosa del matemático se produjo en 1944. John von Neumman se percató del potencial que podrían tener las computadoras electrónicas. Por aquellos años la Universidad de Pensilvania también desarrollaba el ENIAC, el primer ordenador digital de propósito general de la historia. Hasta aquel momento el término "computadora" se refería a "persona que realiza cálculos matemáticos".

IMAGEN: Equipo de tabulación de tarjetas de IBM 601 durante el proyecto Manhattan. Los Alamos National Laboratory.

En abril de ese año llegaron a Los Álamos las primeras computadoras IBM 601, calculadoras basadas en tarjetas perforadas. Para resolver numéricamente las ecuaciones fluido-dinámicas, primero se traducían a un sistema de ecuaciones algebraicas. Luego dicho sistema se codificaba en las tarjetas y se enviaban en lotes a través de una secuencia de computadoras.

John von Neumann pasó dos semanas cableando las computadoras y familiarizándose con los cálculos. Richard Feynmann estuvo a cargo de la codificación. Finalmente, el primer informe sobre simulación numérica fue publicado el 20 de junio de 1944.

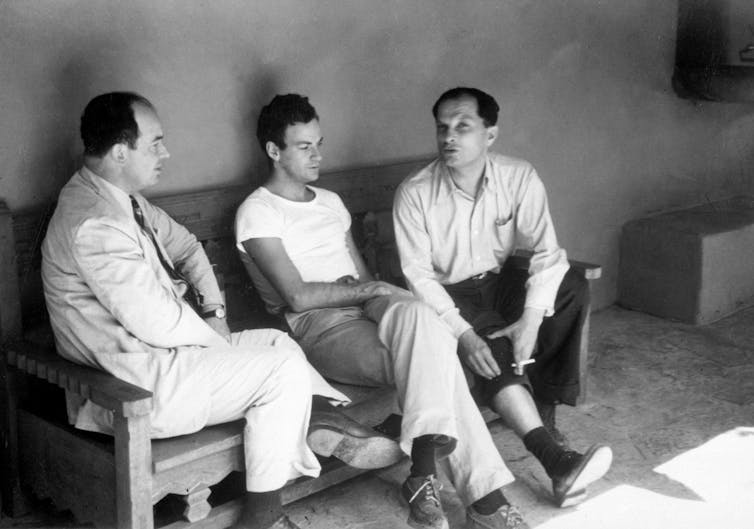

IMAGEN: Los físicos John von Neumann, Richard Feynman y Stanisław Ulam (de izquierda a derecha). Los Alamos National Laboratory.

La importancia de la estabilidad numérica

Se utilizaron dos métodos numéricos para el cómputo de las ondas de choque: el shock fitting desarrollado por Rudolf Peierls y el shock capturing por Von Neumann. Sin embargo, el método de Von Neumann falló catastróficamente. Era necesario añadirle disipación a la onda de choque para que fuera estable.

A raíz de esto, en 1950 logro mejorar su método (artificial viscosity method) y formalizar una teoría para la estabilidad numérica (Von Neumann stability analysis).

Tras el Proyecto Manhattan y hasta su muerte en 1957, Von Neumann participó en el diseño de la EDVAC. Desarrolló una arquitectura de computadoras propia y la IAS machine. Finalmente, encontró un uso hoy sobradamente conocido para las computadoras: la predicción meteorológica.

El MANIAC y la era IBM

Finalizada la Segunda Guerra Mundial, Los Álamos siguió trabajando en el diseño y perfeccionamiento de armas nucleares. También la construcción de la computadora MANIAC I en 1949. Uno de los objetivos era simular las condiciones necesarias para detonar una bomba H tipo Teller-Ulam. Los cálculos previos se realizaron con el ENIAC, pero no fueron concluyentes.

Con la llegada de las grandes computadoras de la compañía IBM en 1953 a los Álamos, el grupo T-3, liderado por Francis Harlow, propició otra gran revolución en la dinámica de fluidos computacional.

La revolución numérica tras la bomba atómica

Durante más de tres décadas desarrollaron métodos numéricos que aún a día de hoy son referentes. Destacan la formulación Streamfunction-Vorticity para flujos incompresibles 2D, el método Marker-and-cell para flujos con lámina libre y el modelo de turbulencia k-epsilon. Aunque la versión final de este modelo se debe a Launder y Spalding (1972), del Imperial College London.

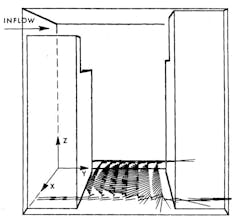

IMAGEN: Simulación del flujo de aire en una calle encajonada. Hotchkiss R.S. and Harlow F.H. (1973), Air pollution transport in street canyons, EPA-R473-029.

La aplicación de los métodos desarrollados por el grupo fue diversa. Desde la refracción de ondas de choque sobre interfaces oblicuas, formación de resaltos hidráulicos, hasta flujo relativista para colisiones de iones pesados.

Merece la pena destacar el trabajo de Reed y Hill en 1973. Desarrollaron la primera versión de un método de Galerkin discontinuo para resolver la ecuación de transporte de neutrones, ecuación que describe el flujo de neutrones a través de un medio fisible no homogéneo, como en un reactor nuclear.

Lo vivido en Los Álamos desde su creación fue una verdadera explosión –tanto metafórica como literal– de ingenio para resolver los complejos cálculos. Allí, grandes genios desarrollaron una nueva manera de proceder con los problemas hidrodinámicos e inspiraron a muchos otros científicos sobre la modelización numérica sin la que hoy en día difícilmente podríamos explicar el mundo.

Víctor Javier Llorente Lázaro, Investigador en Matemática Aplicada, Universidad de Granada.

Este artículo fue publicado originalmente en The Conversation. Lea el original.

Ya no se pueden votar ni publicar comentarios en este artículo.

No esperaba leer acerca de cfd en vozpópuli, enhorabuena por el nivel, mucho mayor que el típico artículo de ciencia en periódico generalista.

Respecto a los comentarios, la película tiene interés hasta que estalla la bomba luego es un pastiche de politiqueo entre bambalinas bastante aburrido. Además tiene omisiones graves, Fermi sale en dos planos mal contados y Szilard en uno sólo.

Oppenheimer no era el personaje más interesante para hacer una película sobre el proyecto Manhattan.

Son tantas las cosas que no cuenta la película...

Me decepcionó que no diese una mínima imagen del enorme despliegue humano, material y económico que supuso.

Por ejemplo, aquellas monstruosas plantas como la de Oak Ridge para obtener uranio enriquecido en el isótopo 235 con 2,892 etapas de difusión gasesosa, levantadas de la noche mañana, con un poblado de 13,000 personas para los trabajadores incluido.

A fin de cuentas, Oppenheimer se hizo famoso por el proyecto Manhattan básicamente, qué menos que dar una idea de su magnitud.

Sin embargo, según la película parece que todo se reducía a un club de chicos muy listos viviendo con sus familias en un lugar desértico muy alejado de todo.