Conocer lo que sucede en nuestro cerebro mientras recibimos un estímulo es uno de los objetivos clásicos de la neurociencia. Pero, ¿qué sucede si afrontamos el problema a la inversa? Desde hace algún tiempo el trabajo de algunos equipos se centra en descifrar qué está pensando, soñando o imaginando el individuo a partir de su actividad neuronal. Una especie de plan de ingeniería inversa para leer la mente.

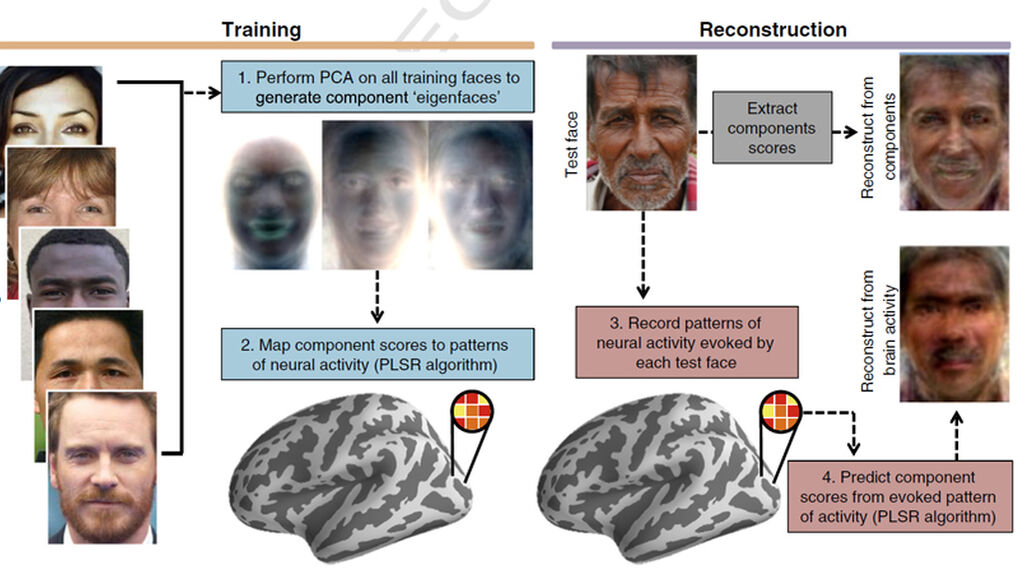

El último trabajo en este campo lo presentaba hace unos días un equipo de la Universidad de Berkeley, quienes han desarrollado un programa que permite obtener una imagen de la cara que la persona está visualizando con solo analizar su actividad cerebral. Para el trabajo, publicado en la revista Neuroimage, los investigadores grabaron la actividad neuronal de los voluntarios mientras visualizaban una serie de 300 fotografías de caras. Con los datos, enseñaron a un programa de ordenador a reconocer determinados patrones, como el sexo, la edad, el color de la piel o la expresión de su propietario. A continuación, pusieron a prueba su algoritmo y compararon lo que éste predecía y la cara que de verdad estaban viendo. Y el resultado, según sus autores, es "sorprendentemente exacto".

Imagen del experimento para descifrar caras

Este tipo de resultados, sugiere el equipo de Alan S. Cowen autor del trabajo, "abren un camino para reconstruir experiencias visuales - incluyendo sueños, recuerdos e imaginaciones - que se producen principalmente en las áreas superiores de la corteza cerebral". Hace unos meses, el equipo de Tomoyasu Horikawa diseñó un sistema para intentar obtener información sobre lo que vemos en los sueños. Con una aproximación parecida, el investigador japonés registró la actividad cerebral de las personas mientras dormía y las despertaba periódicamente para saber qué veían. Cruzando los datos, lo único que consigue, por ahora, es predecir a qué categoría semántica pertenece el objeto con el que sueña el individuo: si sueña con comida, con otra persona, si la escena transcurre en un edificio o si es en la calle, pero confía en poder avanzar hasta conocer más detalles.

Más impresionante es el trabajo del investigador de la Universidad de Berkeley, Jack Gallant, quien demostró en la revista Current Biology en 2011 que tras analizar la señal cerebral de los sujetos mientras veían distintos clips de película era capaz de reproducir una pequeña copia de los patrones visuales principales. Al cruzar la información de la actividad cerebral, el programa de ordenador reproducía una especie de copia borrosa de lo que el individuo estaba viendo:

El sistema visual no es el único que está siendo 'hackeado'. El otro gran terreno en el que se están dando grandes pasos es el del análisis del lenguaje en el cerebro. Algunos estudios indagan en la posibilidad de saber lo que una persona está pensando a partir de la actividad que se genera en el área del lenguaje. Aunque aún es solo una hipótesis, algunos científicos creen que cuando pensamos se produce una activación análoga a la que se produce cuando hablamos - una especie de discurso interno - y que se podría tratar de descifrar el pensamiento por esa vía.

Se puede identificar, por la actividad eléctrica, el sonido que escucha el cerebro

El trabajo recién publicado en la revista Science por Nima Mesgarani, de la Universidad de Columbia, aborda el problema desde otro punto de vista: analizando la actividad cerebral de los voluntarios mientras escuchan distintos discursos, ha encontrado pequeños bloques de actividad neuronal que corresponden con determinados sonidos, de modo que pueden identificar cuándo la persona está escuchando una vocal, una consonante, e incluso si ésta es una consonante fricativa u oclusiva. Si conseguimos desarrollar un programa que identifique la actividad cerebral con los fonemas escuchados, podríamos tener un traductor simultáneo que supiera lo que escuchamos mirando solo las neuronas.

Por supuesto, el asunto es bastante más complicado que todo esto y los sonidos no tienen una traducción mecánica en el cerebro, que activa muchas regiones, pero estos pequeños pasos pueden servir para desarrollar tecnologías de accesibilidad, como las que ya permiten comunicarse a personas con una inmovilidad total o parcial. Otro de los problemas es que la señal cerebral de cada individuo es diferente de los demás, con lo que a la hora de diseñar dispositivos deberían ajustarse a las características individuales y, como asegura Alan Cowen, autor del sistema para descifrar qué cara estamos viendo, la tecnología que se está probando - con escáneres y encefalogramas - solo accede a las partes activas del cerebro, es decir, no podríamos acceder a recuerdos almacenados salvo que el individuo los evocara.

- En Next: El secreto de la visión: el cerebro mejora al ojo con su propio 'Photoshop'

Registro de las vocales en el cerebro (Science)

La cuestión de fondo es: ¿se podrá descifrar algún día toda esta información y abordar lo que sucede en el cerebro como si estuviéramos analizando una máquina? Para Manuel Martín Loeches, profesor de psicobiología de la Universidad Complutense, no hay mayor impedimento que el tiempo y los recursos. “Los aspectos relativamente básicos, como la percepción visual de una cara o los fonemas, serán relativamente fáciles de interpretar”, explica a Next, “porque las áreas primarias de la corteza son muy típicas y las señales auditivas y visuales aparecen repartidas como en un mapa; si ves un círculo, en la corteza occipital se puede ver un círculo de activaciones, es a veces como un espejo”. Otro asunto, apunta, es interpretar otros pensamientos más profundos o incluso los sueños, entre otras cosas porque las imágenes no están tan definidas y el lenguaje en el que se desarrollan- que algunos llaman el “mentalés” – es mucho más ambiguo y vago, y sería mucho más complicado de interpretar.

El gran objetivo es encontrar el algoritmo matemático que emplea el cerebro para descifrar una imagen

La dificultad estriba en llegar a interpretar la actividad del cerebro es un escenario real y no en el sistema cerrado de los experimentos. En estas primeras pruebas, matiza, los científicos buscan la señal de un estímulo que ya están buscando - las diez caras o elementos que los individuos ya han visto. Si los investigadores trataran de interpretar la señal de cualquier otro estímulo de la vida real no tendrían ni idea de qué se trata, y conseguir eso necesitará sobre todo grandes recursos de computación.

La clave para eso está en encontrar una especie de piedra filosofal del cerebro. “Necesitas encontrar el ‘santo grial’ de la neurociencia que todos estamos persiguiendo”, asegura Luis Martínez Otero, investigador del Instituto de Neurociencias de Alicante. “Y es saber exactamente cuál es el algoritmo matemático que emplea el cerebro para descifrar una imagen. Eso todavía no lo sabemos, pero al final es una cuestión de matemáticas, no lo resolverá la biología”. El problema, para Martínez Otero, se limita a nuestra capacidad de análisis. “Encontraremos la forma de descifrar la señal mediante pruebas empíricas, como hemos hecho hasta ahora”, concluye, “porque todo está ahí y no hay ningún dualismo esotérico”.

Referencias: Neural portraits of perception: Reconstructing face images from evoked brain activity (Neuroimage) | Phonetic Feature Encoding in Human Superior Temporal Gyrus (Science) | Reconstructing visual experiences from brain activity evoked by natural movies (Current Biology) | Reconstructing Speech from Human Auditory Cortex (PLOS Biology) Brain decoding: Reading minds (Nature).

Next es la nueva sección de Ciencia y Futuro de Vozpópuli. No te olvides de seguirnos en Twitter

Ya no se pueden votar ni publicar comentarios en este artículo.